- Закон Амдала

-

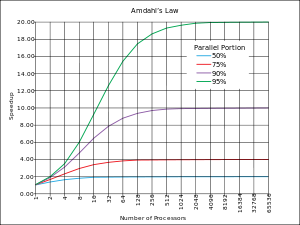

Ускорение программы с помощью параллельных вычислений на нескольких процессорах ограничено размером последовательной части программы. Например, если можно распараллелить 95% программы, то теоретически максимальное ускорение составит 20×, невзирая на то, сколько процессоров используется.

Ускорение программы с помощью параллельных вычислений на нескольких процессорах ограничено размером последовательной части программы. Например, если можно распараллелить 95% программы, то теоретически максимальное ускорение составит 20×, невзирая на то, сколько процессоров используется.

Зако́н Амдала (англ. Amdahl's law, иногда также Закон Амдаля-Уэра) — иллюстрирует ограничение роста производительности вычислительной системы с увеличением количества вычислителей. Джин Амдал сформулировал закон в 1967 году, обнаружив простое по существу, но непреодолимое по содержанию ограничение на рост производительности при распараллеливании вычислений: «В случае, когда задача разделяется на несколько частей, суммарное время её выполнения на параллельной системе не может быть меньше времени выполнения самого длинного фрагмента». Согласно этому закону, ускорение выполнения программы за счёт распараллеливания её инструкций на множестве вычислителей ограничено временем, необходимым для выполнения её последовательных инструкций.

Содержание

Математическое выражение

Предположим, что необходимо решить некоторую вычислительную задачу. Предположим, что её алгоритм таков, что доля

от общего объёма вычислений может быть получена только последовательными расчётами, а, соответственно, доля

от общего объёма вычислений может быть получена только последовательными расчётами, а, соответственно, доля  может быть распараллелена идеально (то есть время вычисления будет обратно пропорционально числу задействованных узлов

может быть распараллелена идеально (то есть время вычисления будет обратно пропорционально числу задействованных узлов  ). Тогда ускорение, которое может быть получено на вычислительной системе из

). Тогда ускорение, которое может быть получено на вычислительной системе из  процессоров, по сравнению с однопроцессорным решением не будет превышать величины

процессоров, по сравнению с однопроцессорным решением не будет превышать величины

Иллюстрация

Таблица показывает, во сколько раз быстрее выполнится программа с долей последовательных вычислений

при использовании

при использовании  процессоров.

процессоров. \

\

10 100 1000 0 10 100 1000 10% 5.263 9.174 9.910 25% 3.077 3.883 3.988 40% 2.174 2.463 2.496 Из таблицы видно, что только алгоритм, вовсе не содержащий последовательных вычислений (

), позволяет получить линейный прирост производительности с ростом количества вычислителей в системе. Если доля последовательных вычислений в алгоритме равна 25 %, то увеличение числа процессоров до 10 дает ускорение в 3,077 раза, а увеличение числа процессоров до 1000 даст ускорение в 3,988 раза.

), позволяет получить линейный прирост производительности с ростом количества вычислителей в системе. Если доля последовательных вычислений в алгоритме равна 25 %, то увеличение числа процессоров до 10 дает ускорение в 3,077 раза, а увеличение числа процессоров до 1000 даст ускорение в 3,988 раза.Отсюда же очевидно, что при доле последовательных вычислений

общий прирост производительности не может превысить

общий прирост производительности не может превысить  . Так, если половина кода — последовательная, то общий прирост никогда не превысит двух.

. Так, если половина кода — последовательная, то общий прирост никогда не превысит двух.Идейное значение

Закон Амдала показывает, что прирост эффективности вычислений зависит от алгоритма задачи и ограничен сверху для любой задачи с

. Не для всякой задачи имеет смысл наращивание числа процессоров в вычислительной системе.

. Не для всякой задачи имеет смысл наращивание числа процессоров в вычислительной системе.Более того, если учесть время, необходимое для передачи данных между узлами вычислительной системы, то зависимость времени вычислений от числа узлов будет иметь максимум. Это накладывает ограничение на масштабируемость вычислительной системы, то есть означает, что с определенного момента добавление новых узлов в систему будет увеличивать время расчёта задачи.

См. также

«Закон Амдала» на Викискладе? - Закон Густавсона — Барсиса

- Закон Мура

- Кластер (группа компьютеров)

Литература

- Антонов А. Под законом Амдала (рус.) // Компьютерра. — 11.02.2002. — № 430.

- Оценка максимально достижимого параллелизма. Лекция из курса «Теория и практика параллельных вычислений» на сайте Института дистанционного обучения ИНТУИТ

Категории:- Параллельные вычисления

- Знание

- Научные законы

Wikimedia Foundation. 2010.